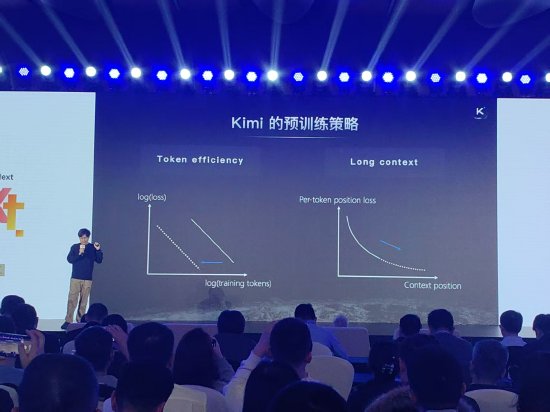

新浪科技讯 1月10日晚间消息,清华大学北京重点实验室、智谱AI发起的AGI-Next前沿峰会上,月之暗面Kimi创始人、CEO杨植麟公开分享了Kimi预训练遵循的两大策略:第一,提升Token Efficiency;第二,实现长上下文(Long context)。

杨植麟指出,Transformer的架构优势体现在长上下文场景中。实验表明,当上下文长度增加到1000个token时,代表Transformer的性能表现会显著下降到LSTM之下,显示出卓越的性能。这揭示了架构在不同上下文长度下的优势差异,是一个至关重要的指标。尤其在当前的Agentic(代理智能)时代,因为许多Agent任务要求极长的上下文来完成高度复杂的指令,因此一个拥有更低positional loss(位置损失)的架构,意味着它在执行Agent任务时具备更强的技术潜力。

基于此,杨植麟指出,月之暗面的预训练策略,乃至整个模型的设计策略,均是围绕提升token efficiency和实现long context展开。

为什么要关注Token efficiency,本质上是因为Agent的推理或训练是搜索过程,比如你想从零开发一个Linux,本质上是搜索问题,如果你有无限的数据,可以把所有可能的情况枚举遍,选出好的操作系统方案。但你让AI开发Linux,这个过程中并不需要枚举每一种可能的Token组合情况,因为很多组合是没有意义或错误的,更好的预训练和基础模型是减少了搜索空间,提升了更好的先验。

杨植麟还进一步指出,除了架构、更好的数据等挑战,做AI模型研究很重要的是要有更多的Taste——即品位和审美。“我觉得模型是一个很不一样的东西,做模型的过程本质是在创造一种世界观,你觉得什么样的东西是好的,一个好的AI应该是有什么样的,应该追求什么样的价值观,有点像乔布斯讲的(Taste)。”杨植麟表示。

杨植麟指出,智能和很多别的东西不一样,每个模型产生的Token,本身不是一个可交换的东西,如果今天看很多事情是相同的,是等价交换,但智能并不是这样的。“一个CEO产生的智能,和一个设计师产生的智能是不同的,因此在智能维度,你有非常多的Taste的空间,空间是指数增加,会有更多新的Taste出来。”杨植麟表示。(文猛)

海量资讯、精准解读,尽在新浪财经APP

海量资讯、精准解读,尽在新浪财经APP

责任编辑:凌辰

鼎盛配资提示:文章来自网络,不代表本站观点。